2024. 5. 31. 15:30ㆍ메타코드/머신러닝

메타코드의 머신러닝 강의입니다.

2강 분류 :: Logistic Regression

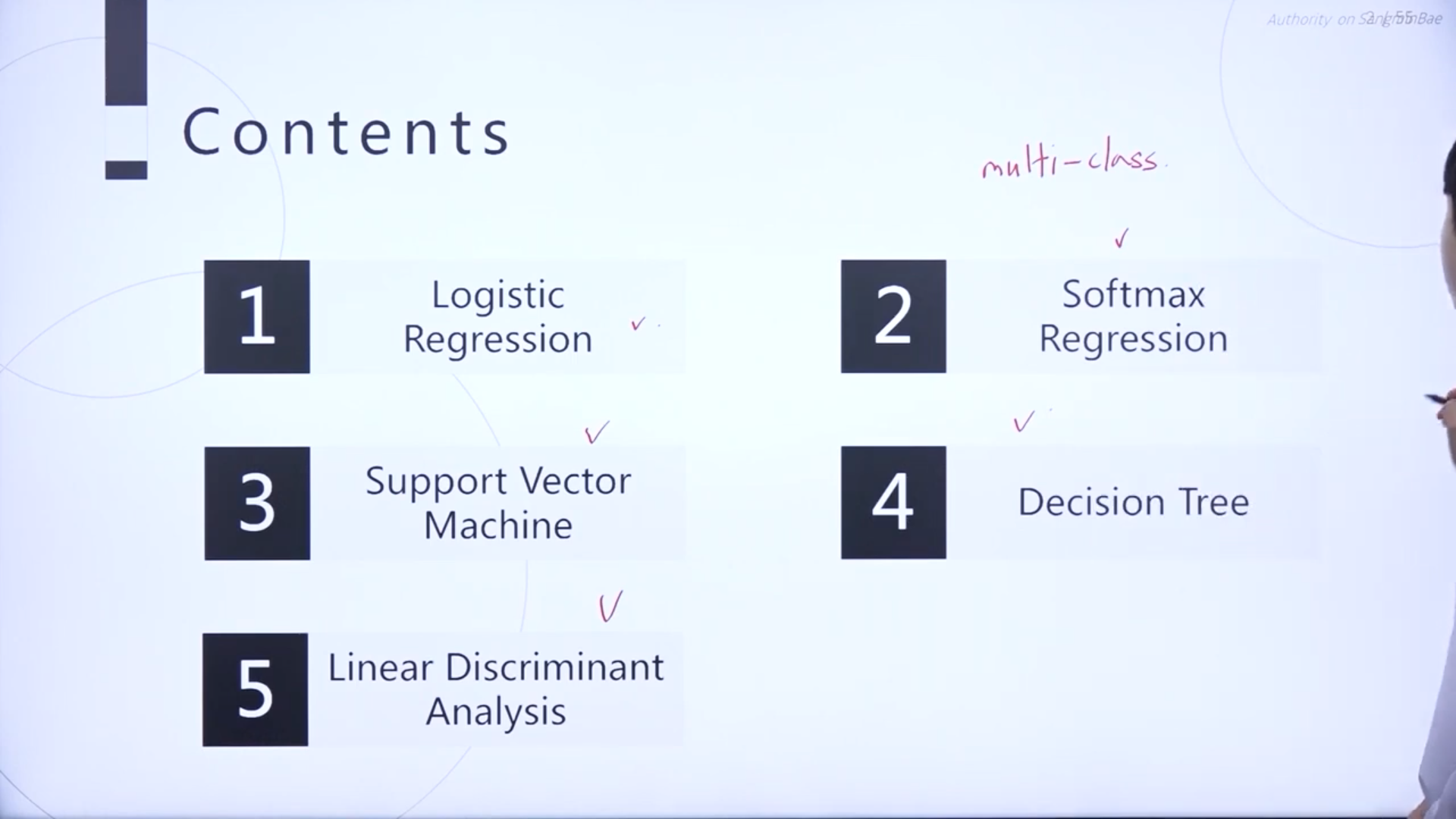

이번 강의에서는 분류 모델에 대해 배운다.

분류 모델에 관련하여 앞으로 배울 것들.

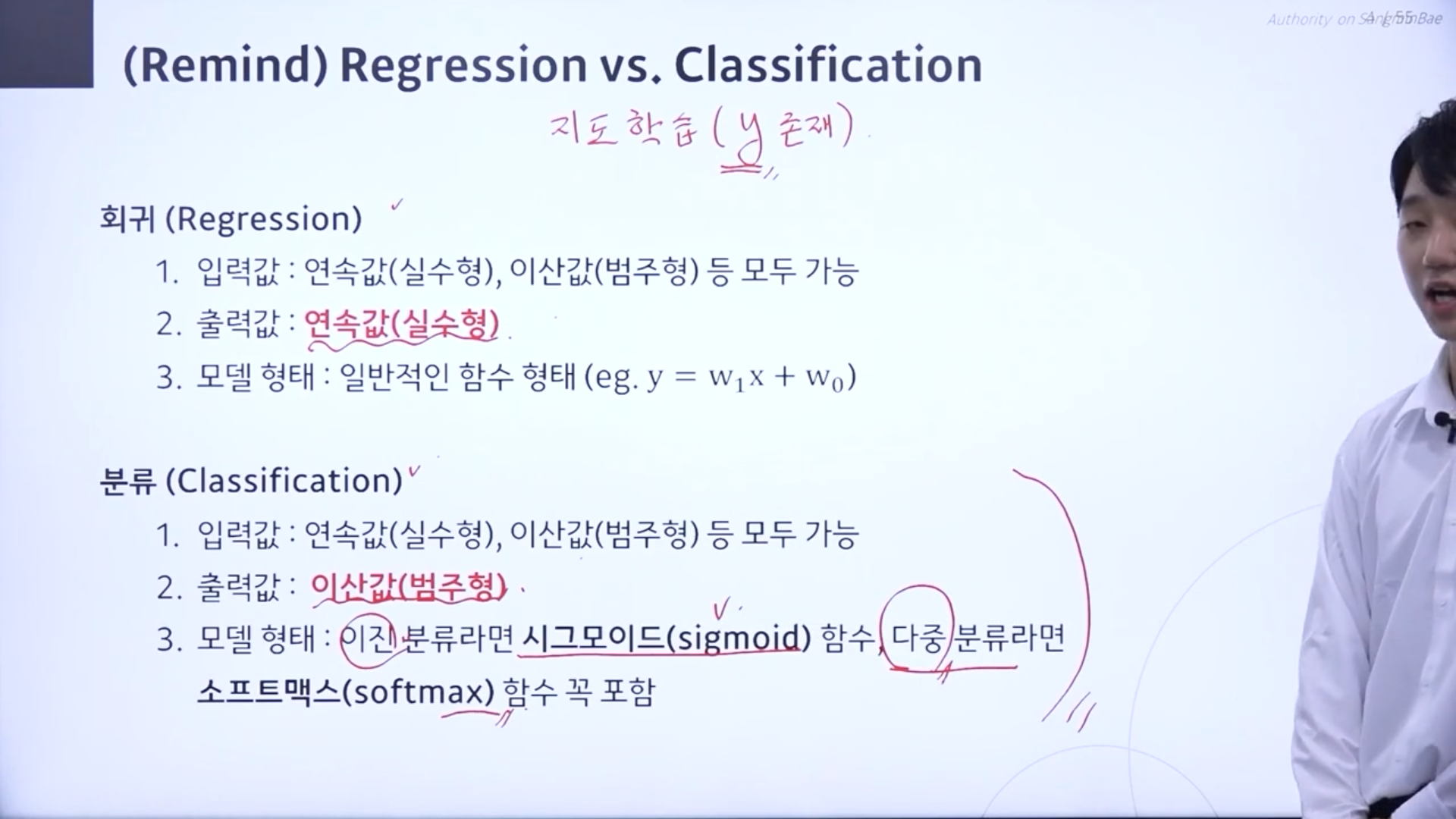

회귀vs분류

지도학습(y존재)의 종류가 연속값의 형태인지 이산값의 형태인지.

분류보델에서는 이진 분류라면 시그모이드 함수를 사용하고 다중 분류라면 소프트맥스함수를 사용한다.

회귀

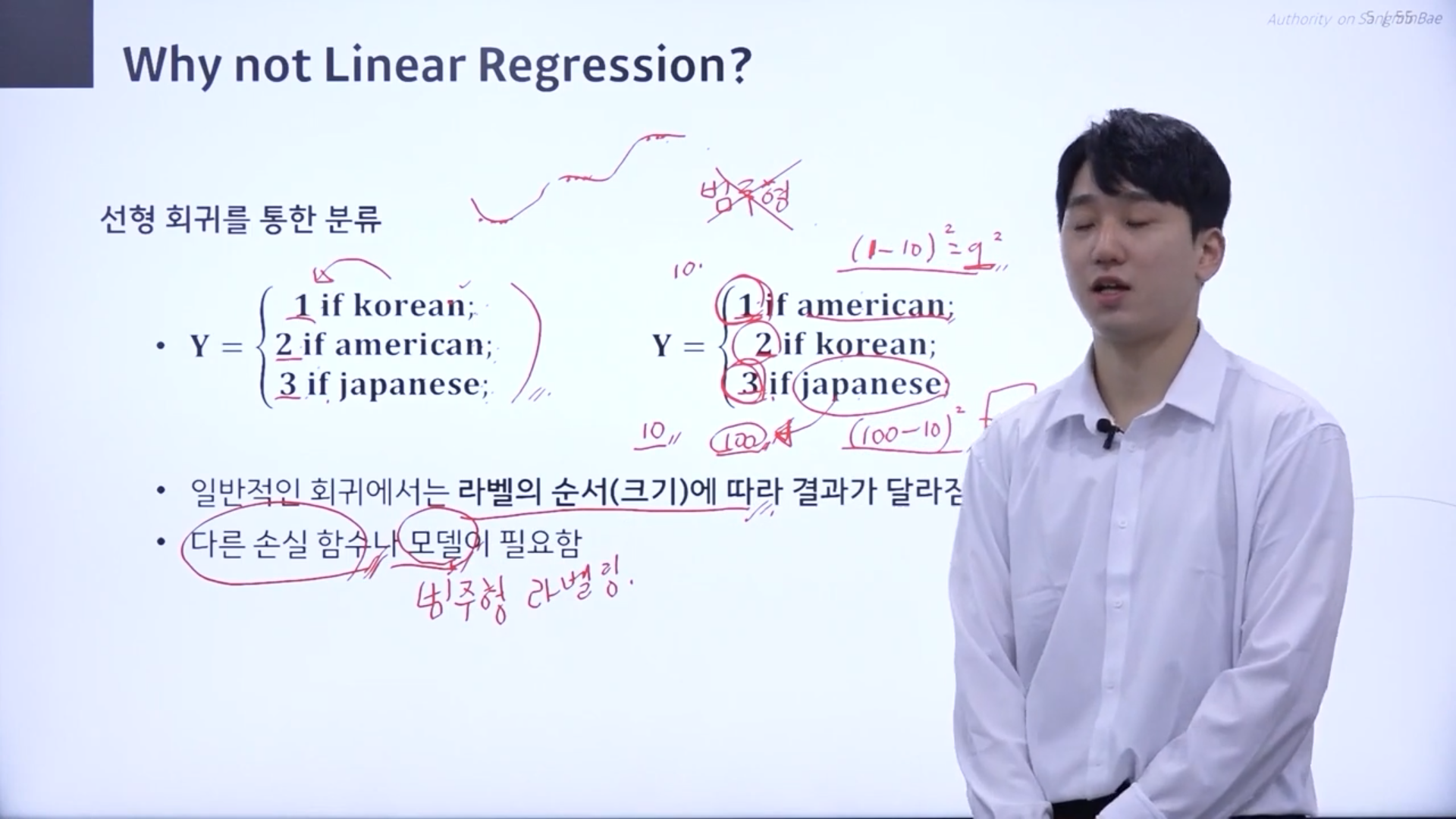

->라벨의 값이 100이면 연속형의 값에다가 라벨을 부여해줬을때 라벨값이 10으로 도출되면 (100-10)의 제곱의 손실. 라벨값이 1이면 (1-10)의 제곱의 손실. 손실이 큰 100라벨 값에 대해서는 더 잘 학습하려고 하지만 10라벨에 대해서는 굳이 잘 안맞추려고 하는 문제점 생김.

=> 다른 손실 함수 필요 => 범주형 라벨링

숫자의 크기값이 중요한 것이 아니라 다른 숫자값(범주형)으로 라벨링이 됐다는 것이 중요

이진 분류 상황->시그모이드 함수

병이 있을땐 0, 병이 없을땐 1 으로 각각 라벨을 부여한다.

x가 0일때는 2분의1. -무한대에 가까워질수록 0에 가까워지고 무한대로 가까워질수록 1에 가까워짐.

로지스틱 회귀

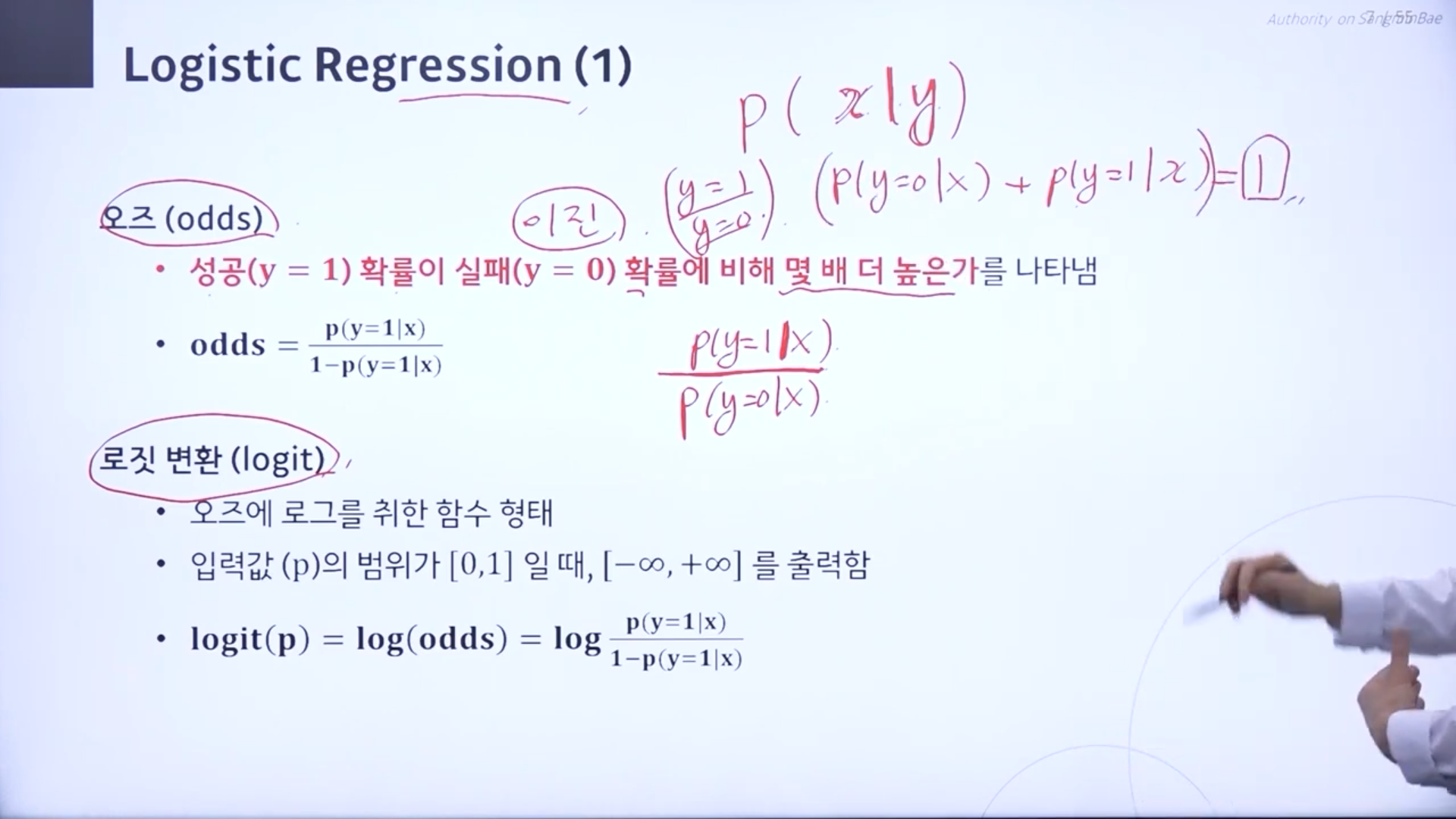

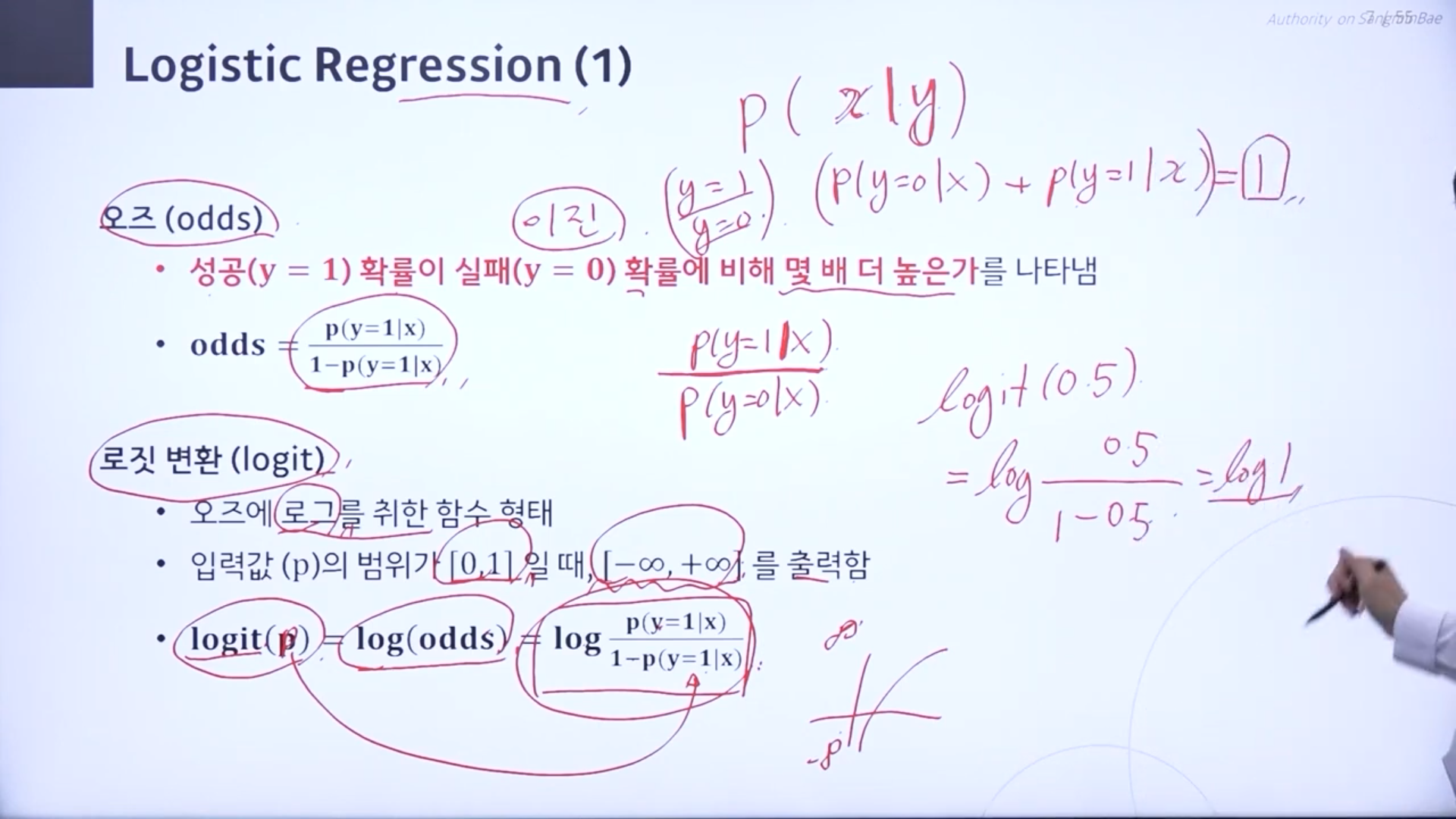

오즈(odds) : 성공확률이 실패 확률에 비해 몇배 더 높은가를 나타냄

P(x|y) : y라는 변수가 주어졌을때 x가 내포하는 확률.

-> y=1 성공할 확률, y=0 실패할 확률 -> P(y=0|x)분의 P(y=1|x)

두 확률을 더하면 1

로짓 변환 : 오즈에 로그를 취한 함수

->일종의 함수. logit(P)-> log(odds) 오즈에 로그를 취한 상태.

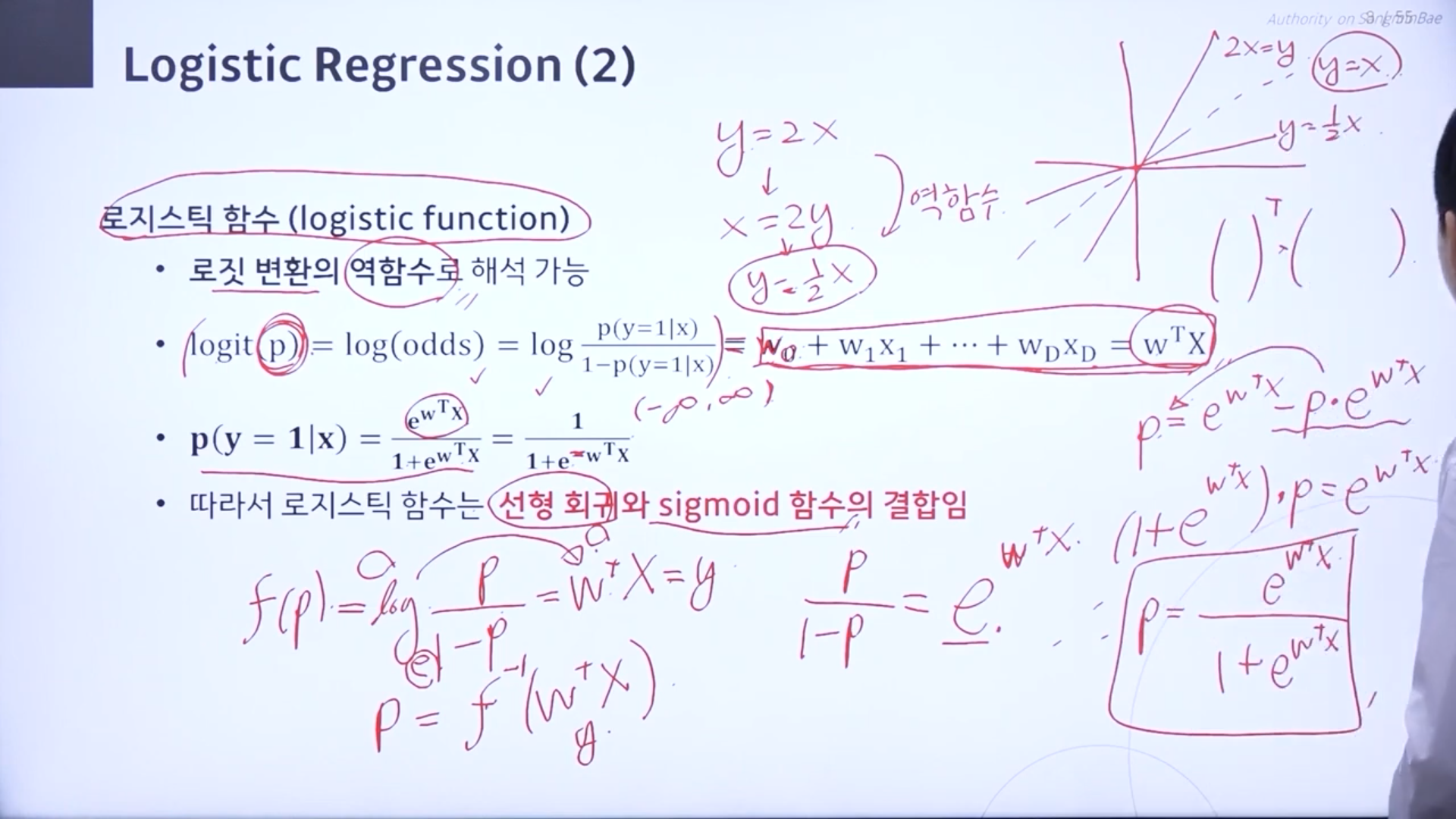

로지스틱 함수 : 로짓 변환의 역함수

역함수 : x와 y를 뒤바꾼 후 y에 대해 정리한 것.

->로짓변환에 역함수를 취하여 정리해주면 선형 회귀와 시그모이드 함수의 결합이 됨.

0보다 크면 1로 분류. 0보다 작으면 0으로 분류

w의 값이 최적화가 되는 손실함수는?

경사하강법을 사용하지만 손실함수를 분류를 위해서 필요한 손실함수에 대해 배워야한다.

x는 데이터로 주어지는 값. p(x)는 쉽게 구할 수 있기때문에 알아도 몰라도 필요없음. 분자만.

사후확률 : 좌변형태. x(데이터)가 주어졌을때 w(가설)애 대한 신뢰도를 보겠다.

우도확률 : w가 주어졌을때 x의 분포. 가설을 잘 모르지만 안다고 가정.

사전확률 : w에 대한 분포가 이렇게 존재할것이다 라고 우리가 던저주는 것.

다음시간에는 MLE와 MAP에 대해 배운다.

괜히 인공지능에 수학이 중요하다고 하는 게 아니구나...점점 수학의 향현이다ㅠㅠ내가 직접 풀어봐야 이해가 더 잘 될 것 같다.

'메타코드 > 머신러닝' 카테고리의 다른 글

| [머신러닝] 머신러닝 입문 올인원 :: 2강 분류_MLE / MAP (2) | 2024.05.31 |

|---|---|

| [머신러닝] 머신러닝 입문 올인원 :: 1강 회귀_Validation Data (1) | 2024.05.31 |

| [머신러닝] 머신러닝 입문 올인원 :: 1강 회귀_Bias and variance Trade-off (0) | 2024.05.31 |

| [머신러닝] 머신러닝 입문 올인원 :: 1강 회귀_Gradient Descent (0) | 2024.05.30 |

| [머신러닝] 머신러닝 입문 올인원 :: 1강 회귀_Least square method (0) | 2024.05.05 |