2024. 5. 5. 23:52ㆍ메타코드/머신러닝

1강 회귀 :: Least square method

optimal -> *로 표현

optimization -> W0*을 뽑아내는 것

편미분

원하는 변수에 대해서만 미분. 다른 것들은 상수로 취급.

델타로 표현.

연쇄법칙

미분을 한다고 가정할때,

미분을 표현하는 식은 분수 형태임. du/du 를 곱해줌.

u라는 새로운 변수를 도입을 시켜서 y에 대해서 u로 미분하고(step1), u에 대해서 x로 미분하는 것(step2)

2가지 step으로 쪼개보는 것.

손실함수에 대해서 정의할 수 있어야 함. (어떤 문제를 정의하였고 어떤 모델을 정의한 이후에)

문제에 대한 손실함수.

회귀문제에 어울리는 회쉬함수가 존재하고 분류문제에 어울리는 손실함수가 존재함. 분류문제는 다음시간에

회귀문제에서는 MSE가 쓰임

평균 제곱 오차(MSE)

실제값과 예측값의 오차. 그 값을 제곱하는 것. 제곱한 값들의 평균.

i라는 인덱스를 도입할때, i는 1부터 N까지의 데이터의 수.

최적의 파라미터 구하기.

최소 제곱법

y헷 부분은 정의한 모델(단순선형회귀)의 함수.

손실함수값을 최소화 시키는 법

(풀이방법1)

손실함수에 대한 a라는 파라미터의 편미분 값이 0이다

손실함수에 대한 b라는 파라미터의 편미분 값이 0이다

최소값의 접선의 기울기는 0이다.

함수식을 u로 두고 대입하고 계산.

완벽한 해 a*,b* -> a와 b의 최적값을 구할 수 있다.

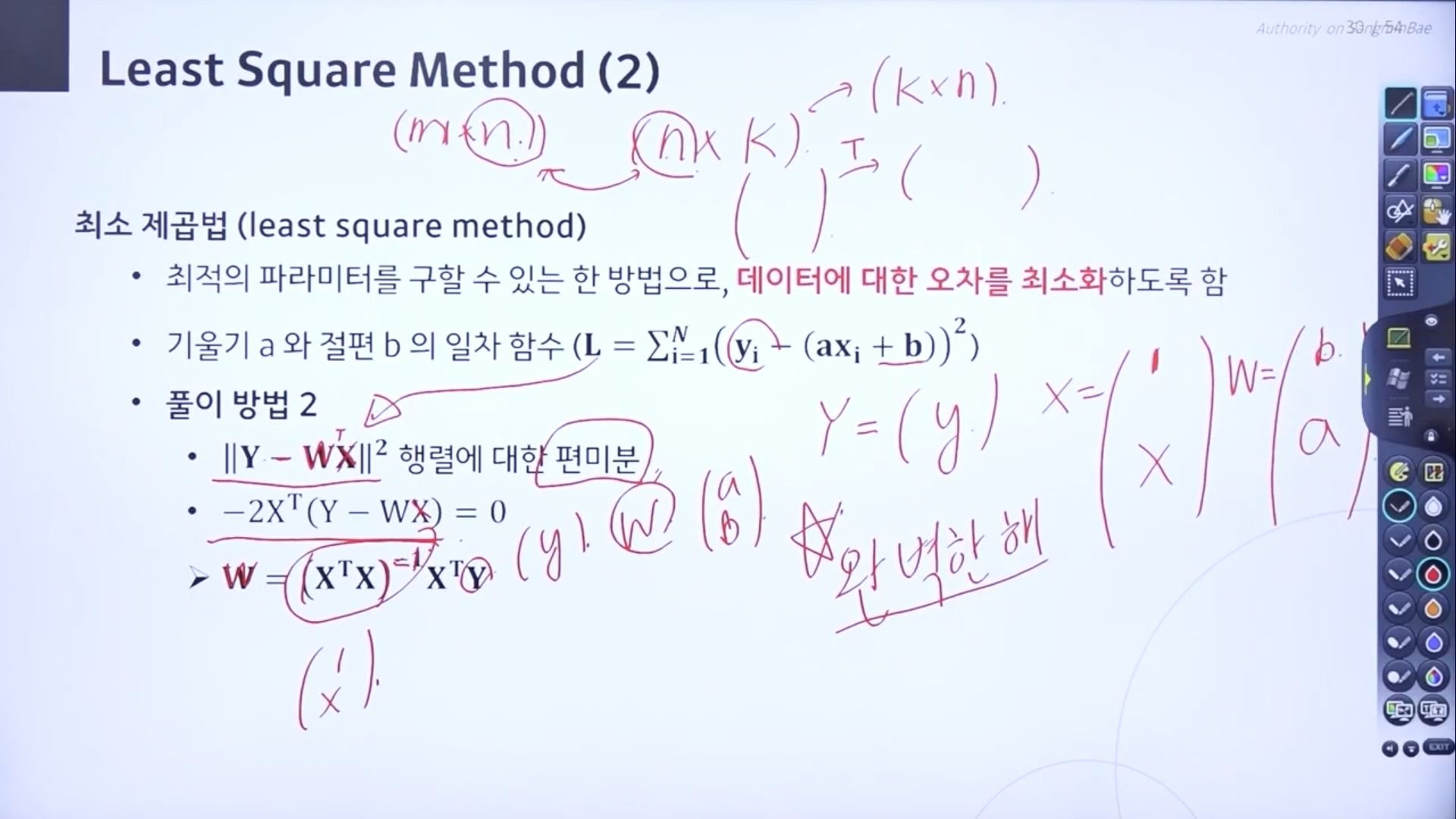

(풀이방법2)

행렬로 풀이.

x의 평균값,y의 평균값 구하기.

완벽한 해마저도 오차가 존재. 지금 주어진 데이터를 표현할 수 있는 가장 최적의 값.

정의했던 모델(단순성형회귀)가 완벽하지 않으니 다중선형회귀로 풀면 더 적합한 모델을 찾을 수 있지 않을까? 생각해 볼 수 있음

중간에 썼던 게 전부 날라가도 멘탈도 날라갔다...ㅜ 다시 쓰면서 분명 놓쳐서 못 쓴 부분이 있는 것 같은데, 대신 한번 더 돌려보면서 더더욱 잘 이해하게 된 부분이 있으니..좋게 생각하기로 했다. 최소제곱법의 행렬부분은 이해가 좀 덜 돼서 복습이 필요할 것 같다. 아니 고딩때 수학을 전부 잊어버려서 좀 아쉽다.

'메타코드 > 머신러닝' 카테고리의 다른 글

| [머신러닝] 머신러닝 입문 올인원 :: 1강 회귀_Bias and variance Trade-off (0) | 2024.05.31 |

|---|---|

| [머신러닝] 머신러닝 입문 올인원 :: 1강 회귀_Gradient Descent (0) | 2024.05.30 |

| [머신러닝] 머신러닝 입문 올인원 :: 1강 회귀_Linear Regression (0) | 2024.05.05 |

| [머신러닝] 머신러닝 입문 올인원 :: 1강 회귀_Basic Math for ML (0) | 2024.04.21 |

| [머신러닝] 머신러닝 입문 올인원 :: 1강 회귀_Notation (0) | 2024.04.21 |